北京科技大学 吴延鹏 贾洁 于震 李怀 崔向红

【摘 要】本文针对北京地区12处数据中心能耗进行调研,得到了数据中心的总电耗及各设备所占的电耗比例,分析数据中心投入使用时间、规模、制冷形式等参数对PUE的影响。根据调研结果,利用DeST对其中某一典型数据中心的空调系统进行节能优化,制定完整的节能改造方案,为现有数据中心进一步节能改造提供参考与依据。

【关键词】数据中心 能耗调研 模拟分析

Abstract:This article investigates the energy consumption of 12 data centers in Beijing., and obtains the total power consumption of the data center ,the proportion of the power consumption of each device., and analysis the impact of the parameters such as the data center's time of use, scale, and cooling format on the PUE. According to the research results, DeST was used to optimize the air conditioning system in one of the typical data centers, and a complete energy-saving reconstruction plan was developed to provide reference and basis for further energy-saving transformation of existing data centers.

0 引言

近几年,我国数据中心发展迅速,2015年我国数据中心突破1500万平方米[1],而其日益突出的能耗问题也越来越不容忽视,2015年数据中心的电耗为1000亿度,年耗电量超过全社会用电量的1.5%[1]。据调查,国外数据中心采取多样的节能改造措施,将PUE平均值控制在1.2以下[2]:美国俄勒冈州Facebook数据中心,通过在顶部修建巨大的中央通风系统和蒸发间,让干空气带走热量,将PUE控制在1.05~1.10[3];芬兰哈米纳的Google数据中心,利用海水循环降温,将PUE控制在1.14[4];冰岛雷雅内斯巴的Verne Global数据中心,采用当地丰富、便宜的地热和水力资源供电,利用冰岛天然的寒冷,干燥的天气用于设备降温,将PUE值控制在1.2[5]。而我国数据中心能源利用效率水平整体偏低,我国的大多数数据中心的PUE值大于2.0,平均值更是高达2.5[6]。但研究表明,应用现有节能技术,可使数据中心IT设备系统、空调系统、配电系统平均实现节能25%、36%和18%[7],使数据中心整体平均实现节能35%[8]。因此,对我国数据中心进行节能优化是十分有必要的。

1 数据中心能耗调研

1.1 调研对象及内容

本次调研对象为北京市12处数据中心,其基本信息见表1。本次调研对象从投入使用时间、规模以及制冷形式来看,基本涵盖了北京市所有数据中心的类型,选取的数据中心样本具有一定的代表性。调研内容包括数据中心基本信息、能源评价信息、能耗指标信息、能源管理系统信息。

1.2 调研方法

对主要耗电量(供电系统、制冷系统、照明系统)分别计量,采用2h一次的测量周期。在UPS的输入端与输出端分别安装电表,利用两者差值计量供电系统的用电量。监测制冷系统的用电量应包括室内空调末端,水冷式制冷还包括压缩机、冷冻水泵、冷却水系统、末端冷冻水系统的耗电量。

1.3 调研结果

根据上述方法,得到各数据中心的总用电量、IT设备用电量、空调用电量、可再生能源发电量等能耗指标,整理后得到各数据中心的PUE和CLF值。具体信息如表2所示。

1.4 调研分析

1.4.1 数据中心投入使用时间对PUE的影响

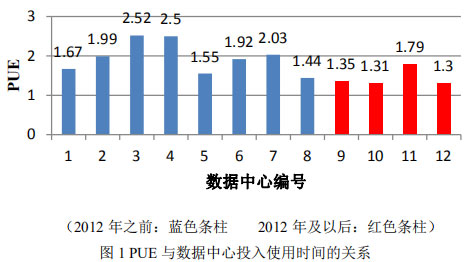

由图1可以看出,2012年后投入使用的数据中心的PUE值基本在1.3-1.8之间,2012年前建成的数据中心的PUE值基本在1.8-2.5之间。说明新建成的数据中心已经开始重视数据中心高能耗的问题,越来越注重节能措施在数据中心中的应用。

1.4.2 数据中心规模对PUE的影响

由图2可以看出,数据中心的面积对于数据中心的能耗指标PUE值有一定的影响。定性地分析,数据中心的PUE与面积的大小基本成反比关系,面积较大的数据中心的PUE值较低,而面积较小的数据中心的PUE值相对较高。

1.4.3 数据中心制冷形式对PUE的影响

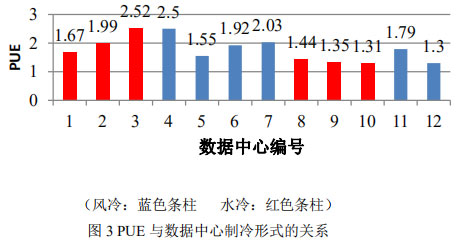

本次调研中,风冷式的数据中心的PUE值基本在1.9左右,水冷式的数据中心的PUE值基本在1.7左右。风冷式直接蒸发式空调系统的初投资成本最低,系统组成简单、器件少、施工简单工期短,但是制冷系统效率低,运行稳定性差,维护成本极高,适用于水源缺乏的地区、小型数据中心[9]。水冷式直接蒸发式空调系统的初投资成本稍高,需要布置冷却塔及空调水系统,但是制冷系统效率高,维护成本低,适用于有集中冷却水系统的场所[10]。因此,风冷式数据中心的PUE值要高于水冷式数据中心。

2 数据中心节能优化

根据上述调研结果,以北京市某数据中心为对象,对其进行DeST能耗模拟及节能优化。该建筑主要功能房间现有的空调系统设计、空气处理设备以及冷热源设计如表3所示。

2.1 空调系统方案改造

对原有空调系统进行改造,提出两种改造方案:

方案一:风机盘管加新风系统,空调系统的运行作息按照办公室空调启停作息,根据人均新风量和维持室内正压最小新风量综合确定房间总的新风量;

方案二:全空气变风量系统,各房间的送风范围4-8次/h。

对上述空调系统方案进行模拟计算,可以计算得到各系统全年满意(系统可达到设计要求)小时数如表4所示,对比发现各房间全年满意小时数有明显增加,有的甚至增加了一倍。

选取全空气定风量系统和风机盘管加新风系统在不满意时刻(3月6号上午9点)各个房间室温和送风量情况,系统大部分需要供热,一部分房间需要制冷。有些房间温度已经达到室温下限,有些房间温度已超出室温要求上限,因为是定风量系统,所以并不能通过风量来调整,从而系统无法同时满足各个房间的要求。选取全空气变风量系统同一时刻,系统大部分需要供热,一部分房间需要制冷。有些房间温度已经达到室温下限,将风量调小可以使房间温度上升,达到室内要求温度;有些房间温度已超出室温要求上限,将风量调大可以使房间温度下降。因此全空气变风量系统可以通过调整各房间的风量来同时满足各个房间的要求。

2.2 空气处理设备方案改造

2.2.1 冷器选型

利用DeST对原有方案全年运行情况进行逐时模拟计算。计算得到,方案不能满足设计送风状态要求的小时数达到295h。针对某一不满足要求的时刻,设备无法将空气处理到此时此刻系统要求的送风状态点S点,只能将空气处理到与其温度相当的O点,但要求的除湿量却相差很大,使室内含湿量过大。因为8排的表冷器的通用换热效率高,湿工况运行时,表冷器处理空气状态点接近饱和线,如果此时将空气从混风状态点M点除湿到与S点等湿值得状态点,空气温度会比送风状态点S点低很多,送风温度无法满足要求,所以此时此刻设备无法同时满足送风温度和湿度的要求。采用4排带旁通的表冷器,通过处理部分空气到低温低湿状态再与未处理空气混合便可以达到送风状态点,可以很好地避免上述问题。

2.2.2 热回收处理方案改造

利用DeST对不设新排风换热器、设置显热回收器、设置全热回收器三种方案进行模拟,比较三种热回收方案的运行能耗。设置显热回收器额定的温度效率为0.7,全热回收器额定的温度效率0.7,额定的湿度效率0.7。模拟得到三种方案的运行能耗依次为18863.6kWh、15562.5kWh、11523.8kWh。该系统采用全热回收的方式运行与不设置热回收装置相比可节省了38%的运行能耗。

2.3 冷热源方案改造

利用DeST对建筑逐时需要冷量分布情况进行分析,分析结果见表5。可以发现,冷量需求在低于1600kW的范围内比较集中,尤其是冷量需求低于1200kW的小时数占到需要开启冷机总小时数的60%。

数据中心最大的冷量需求为2980kW,对此选出两种冷机搭配方案:

(1) 额定冷量为1500kW离心机2台;

(2) 额定冷量为1140kW离心机2台,额定冷量为720kW离心机1台。

本次数据中心采用二次泵水系统形式,冷机的工况和水系统直接相关。上述两个搭配方案所选择的设备参数和台数见表6。

两种方案的冷机总额定冷量相同,都满足系统的逐时冷量需求。系统运行时会根据末端的冷量需求确定开启冷机的台数,随着末端冷量需求的变化,冷机大部分时间会工作在部分负荷点,因冷冻机部分负荷时的COP不同,所以不同的冷机搭配会有不同的运行能耗,运行能耗的差别与系统的负荷分布情况有关。

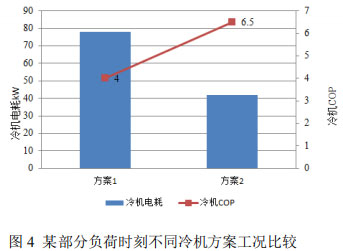

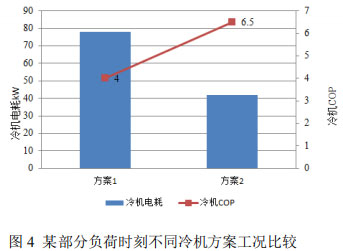

图4所示为某一时刻,不同冷机方案下对应的冷机电耗及COP。对冷机全年运行电耗进行模拟分析,方案1和方案2的全年运行能耗分别为19165kWh和1589 kWh,方案2的冷机搭配方案下的冷机全年运行电耗与方案1相比有明显降低,降低了17%的运行电耗。

2.4 输配系统方案改造

数据中心采用二次泵系统,二次泵的运行方式有两种:根据用户流量需要台数控织,根据供回水压差变频控制。对两种控制方式的水泵运行电耗进行模拟,结合初投资进行经济性分析,来确定二次泵的运行方案。

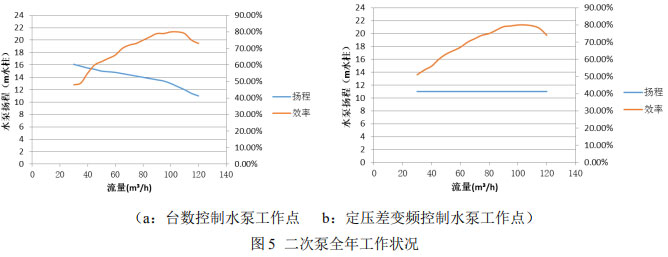

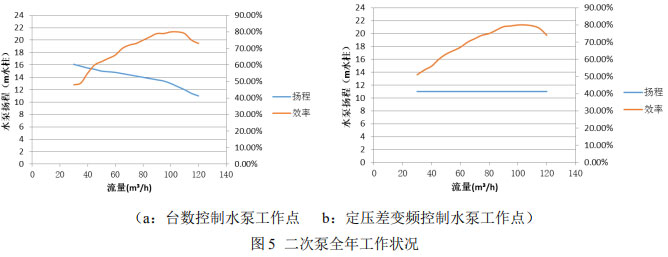

由图5(a)可知,二次泵以台数控制的方式运行,水泵的工作点扬程大部分时刻高于11m。由图5(b)可知,二次泵以变频控制的方式运行,水泵的工作点扬程维持在11m。对两种控制方式的水泵运行电耗进行模拟可得,台数控制与定压差变频控制下的水泵电耗分别为7895kWh、6524kWh,采用定压差变频控制方式可节省电耗16%。

对两种运行方案的二次泵初投资及生命周期运行费进行计算,见表7。因为初投资的增加,变频的寿命周期费用仅略小,对数据中心而言,从经济性角度看,定压变频控制的优势并没有那么明显。

3 结论

本文通过对北京市12个数据中心进行能耗调研和对北京市某数据中心进行能耗模拟,得到如下结论:

(1) 数据中心的能耗指标PUE值与数据中心的规模、等级、制冷形式和使用时间等影响因素有关。投入使用时间在2012年之后的PUE值明显低于之前的数据中心的PUE值。数据中心的PUE与面积的大小基本成反比关系,面积较大的数据中心的PUE值较低,而面积较小的数据中心的PUE值相对较高。风冷式的数据中心的PUE值基本在2左右,水冷式的数据中心的PUE值基本在1.5左右。

(2) 将空调系统改为全空气变风量系统,可以保证室内IT设备的正常运行。将通用换热效率更高的8排表冷器换为通用换热效率4排带有旁通的表冷器,很好地解决了某些不满足要求的时刻无法将空气处理到送风状态点的难题。

(3) 通过设置全热回收装置节省了38%的运行能耗。根据系统对冷热源提出的冷量、热量需求确定选用的冷热源的容量,进行冷机搭配。通过分析数据中心逐时需要冷量的分布情况,选用多台离心机,不光提高了冷机的COP,就全年运行电耗而言,也节省了17%的能耗。

(4) 对二次泵的两种运行方式进行电耗模拟,从节能角度,变频水泵的节能效果优于控制台数,节省了16%的电耗。对两种运行方案进行经济性模拟,从经济的角度来说,控制台数初始投资小,变频水泵并无明显优势。综合两者进行考虑,选定控制台数的运行方式更为适用该数据中心。

参考文献

[1] 于慧.数据中心能耗问题突出[N].中国工业报,2016-06-06(A01).

[2] 谷立静,杨宏伟,胡姗.美国数据中心节能经验和启示[J].中国能源,2015,37(06):26-29+21.

[3] Jinkyun Cho, Yundeok Kim. Improving energy efficiency of dedicated cooling system and its contribution towards meeting an energy-optimized data center [J]. Applied Energy, 2016(165):967-982.

[4] Yong-Il Kwon. A study on the evaluation of ventilation system suitable for outside air cooling applied in large data center for energy conservation [J]. Journal of Mechanical Science and Technology, 2016(30):2319-2324.

[5] Mingrui Zhang, Qingsong An, Zhengwei Long, et al. Optimization of Airflow Organization for a Small-scale Date Center Based on the Cold Aisle Closure[J]. Procedia Engineering,2017,205.

[6] 王振英,曹瀚文,李震.数据中心制冷系统冷源选择及能效分析[J].工程热物理学报,2017,38(02):326-332.

[7] 殷平.数据中心研究(4):关键性能指标、电能使用效率PUE和EEUE[J].暖通调,2017,47(04):36-45+135.

[8] 芮鹤云.数据中心节能评估方法[J].电信快报,2017(10):7-11+33.

[9] 耿云,张萌,胡雨,et al. 某小型数据中心气流组织的试验研究[J].低温与超导,2017,45(01):80-85.

[10] 张兴,李震.数据中心冷却技术发展[J].工程热物理学报,2017,38(01):226-227.

备注:本文收录于《建筑环境与能源》2018年10月刊总第15期(第21届暖通空调制冷学术年会文集)。版权归论文作者所有,任何形式转载请联系作者。